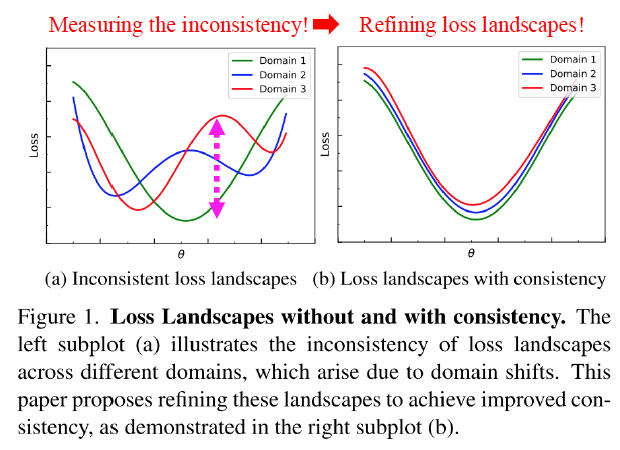

안녕하세요 KDST 한용진입니다. 이번 논문 세미나에서 소개해드린 논문, "Seeking Consistent Flat Minima for Better Domain Generalization via Refining Loss Landscapes"을 살펴보고자 합니다. 논문 제목을 통해 유추할 수 있듯이 loss landscape를 조정해 가며 Domain Generalization을 위해 consistent flat minima를 찾는 방법을 제안하는 논문입니다. SummaryDomain Generalization을 위해서 여러 연구들이 flat minima를 효율적으로 찾는 방법을 제안해오고 있습니다. 그러나 기존 방법들은 서로 다른 도메인 간의 consistency를 고려하지 않는다는 문제점이 존재합니다..