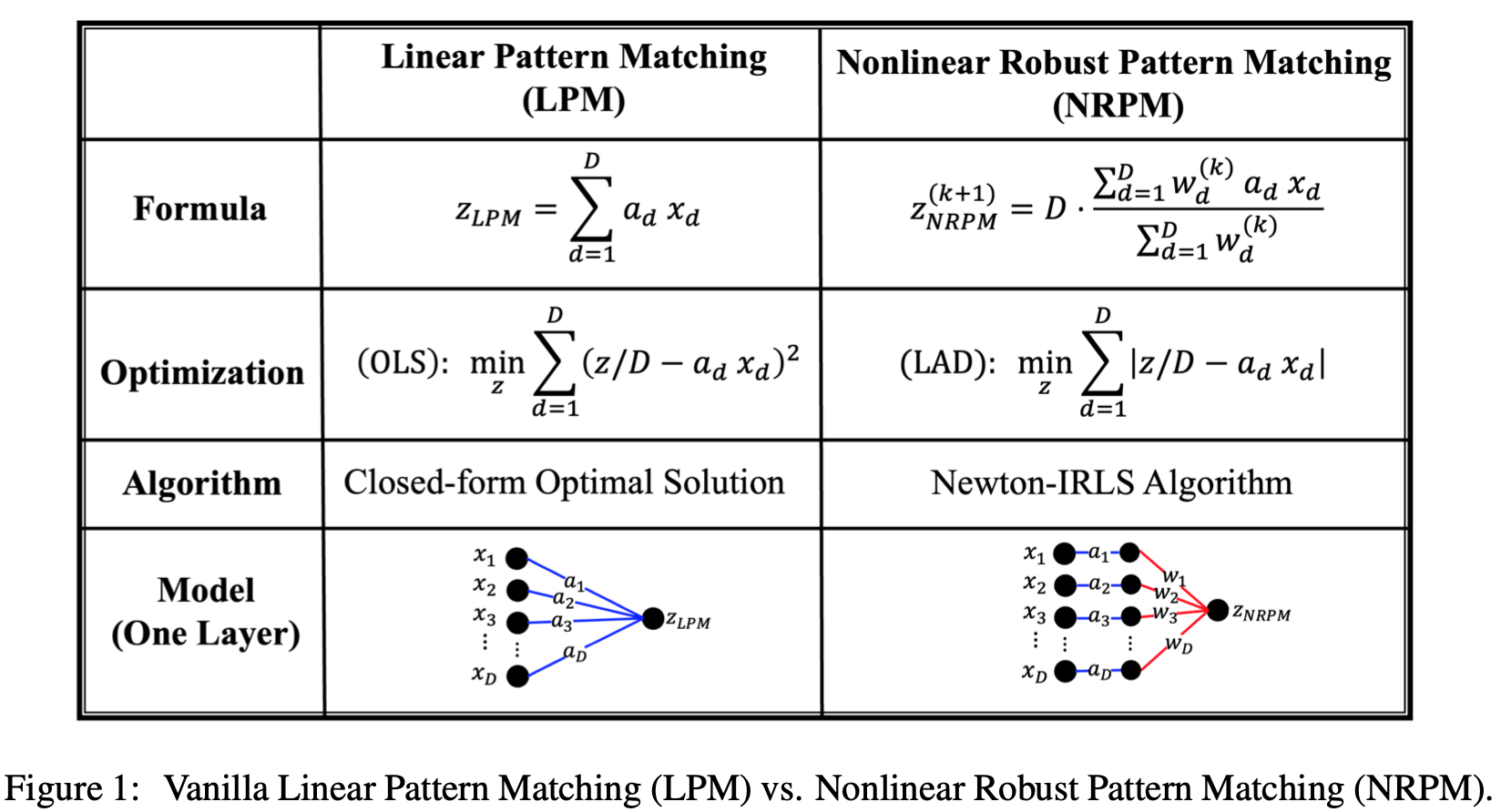

안녕하세요 KDST 한용진입니다. 이번 세미나에서는 2025년도 ICLR에서 발표된 "Robustness Reprogramming for Representation Learning"이란 논문을 발표하였습니다. 논문에 대해 간략하게 먼저 설명을 해보자면, 본 논문에서는 feature의 패턴 매칭 관점에서 신경망 모델의 취약점을 살펴보고 이를 해결하기 위해 비선형 패턴 매칭 방법을 제안합니다. 비선형 패턴 매칭을 통해 유도된 아키텍처로 변환하는 것만으로도 모델의 robustness가 향상됨을 보입니다. Robustness 향상을 위해 고비용의 적대적 학습을 하였던 기존 방법을 벗어나 representation learning 관점으로 재해석하여 추가적인 학습 없이도 robustness를 향상할 수 있음을 보..