안녕하세요 KDST팀 이원준입니다.

금일 진행한 세미나 논문에 대해서 공유드리도록 하겠습니다.

CVPR 2025에 accept된 논문이고, Yann Lecun과 Kaiming He가 저자에 포함되어 있는 논문입니다.

Introduction

최근 Normalization 레이어는 필수적으로 사용되고 있지만,

본 논문에서는 제안한 방법을 통해 이러한 Normalization 없는 trasnformer가 이와 비슷한 성능 혹은 더 나은 성능을 입증한 논문입니다.

본 논문에서는 Normalization을 대체하기 위해, Dynamic Tanh (DyT)를 제안합니다.

위 방식은 굉장히 심플한 방식만으로 기존에 사용되어왔던 Normalization을 대체함으로써 효과성을 입증합니다.

위 그림에서 저자들은 초기 레이어에서는 LN의 인풋과 아웃풋의 시각화를 통해 초기 레이어에서는 선형적인 모습을 띄지만, 레이어가 깊어질 수록 Tanh와 같은 S-shaped curve를 나타내는 것을 관찰합니다.

저자들은 이러한 현상의 원인을 파악하기 위해 coloring을 통해 시각화하였습니다.

1. 토큰별로 시각화 : LN의 특성상 각 토큰들별로 Normalization을 수행하기 때문에, 토큰마다 각기 다른 mean과 variance를 가지게 됩니다. 이로 인해, variance가 작은 x들에 대해서는 강한 기울기를 가지고, variance가 큰 x들에 대해서는 작은 기울기를 가지게 되면서 Figure 4의 왼쪽처럼 점점 S자 모양의 형태를 가지게 되는 것을 확인할 수 있습니다.

2. 채널별로 시각화 : 채널별로 시각화를 해본 결과, 몇몇 채널들이 매우 큰 값을 가지는 현상을 발견하였고, 그러한 값들은 Normalization 레이어에 의해 값이 압축되고 있는 현상을 관찰합니다.

본 논문에서 제안한 DyT는 위와 같습니다.

감마와 베타의 경우에는 LN의 scaling & shift를 그대로 적용하였고, tanh의 인풋에도 scaling을 할 수 있는 알파값에도 learnable한 파라미터를 추가하였습니다.

본 논문에서 제안한 방식은 transformer에서 사용되는 GELU or ReLU와 같은 activation function을 대체하는 것이 아니라, attention block, FFN block, final normailzation layer에 사용되는 normailzation을 대체하는 것임을 유의하시길 바랍니다.

Experiments

본 논문에서는 굉장히 다양한 task와 도메인에서의 실험을 진행함으로써 DyT의 효과성을 입증합니다.

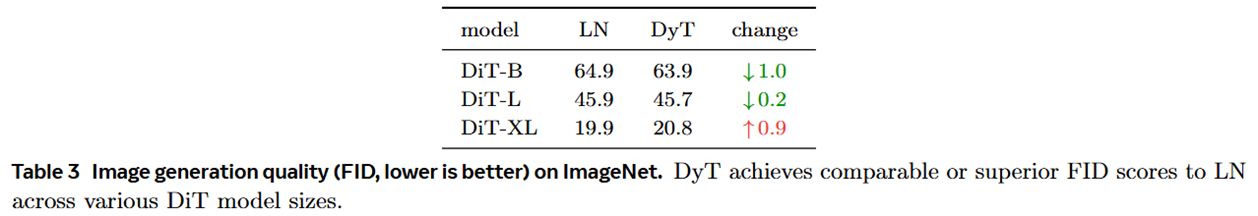

위 실험 결과와 같이 Vision & NLP task에서 사용되는 다양한 Transformer 기반 architecture에서 DyT를 사용함으로써 기존의 LN 혹은 RMSNorm에 비해 우수하거나 동일한 성능을 보임임을 증명합니다.

Analysis

위 테이블은 기존 LN을 더욱 효율적으로 개선하여 LLM에 많이 사용되는 RMSNorm보다 DyT가 훨씬 더 효율적임을 나타내는 결과입니다. 한 layer의 lateny의 경우 40~50% 개선을 이루었으며, 전체 모델에 대해서는 7~8%정도 효율적인 latency를 보여줍니다.

위 실험은 tanh가 아닌 hardtanh, sigmoid와 같은 다른 함수로 변경한 실험입니다. 위 테이블에서 identity는 항등함수로 인풋 값 그대로 아웃풋을 내보내는 항등 함수를 의미합니다. 실험 결과 tanh가 가장 우수한 성능을 보이며, 저자들은 tanh의 smoothness와 zero-centered한 특성 때문에 가능한 현상이라고 설명합니다.

위 실험의 경우 tanh에 스케일링 목적으로 사용되는 알파 값이 훈련 중과 훈련 후에 어떻게 변경되는지에 대한 시각화 그림입니다. 실험 결과, 1/std 값을 따라가는 현상을 관찰할 수 있고, 이는 곧 알파 값이 normalization의 역할을 일부 수행하는 것으로 해석할 수 있습니다.

Conclusion

결론적으로, Deep Neural Networks에서 필수적으로 사용되었던 normalization에 대한 새로운 시각을 열어주는 논문이라고 생각됩니다.

본 글에서 담지 못한 실험과 다양한 ablation study들은 논문을 참고하시면 확인하실 수 있습니다.

감사합니다.