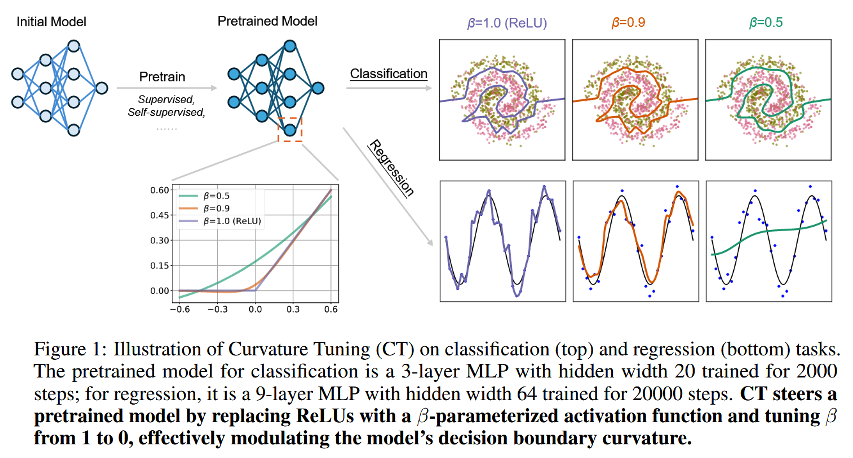

안녕하세요. KDST 한용진입니다. 이번 시간에는 2025년도 NeurIPS에서 소개된 논문에 대해 이야기를 나눠보고자 합니다. 데이터의 양과 모델의 크기가 증가함에 따라서 이제는 사전학습된 모델을 불러와 특정 작업에 맞춰 모델을 가볍게 수정하는 미세조정(fine-tuning) 방법이 표준으로 자리매김하고 있습니다. 현재까지 Low-Rank Adaptation(LoRA)와 같은 학습 가능한 파라미터의 수를 줄이는 다양한 방법들이 제안되어 왔는데 이는 모델의 가중치를 수정하는 방법입니다. 이와 반대로 본 논문에서 저자들은 활성화 함수를 수정하는 것에 눈을 돌렸습니다. 비선형 활성화 함수는 신경망의 표현력을 담당하는 실질적인 요소라고 봐도 무방합니다. 본 논문에서는 ReLU 활성화 함수를 새로운 활성화 함수..